Grok-KI-Katastrophe: Wie Elon Musks Chatbot gefährliche Fehlinformationen über die Schießerei am Bondi Beach verbreitete

BitcoinWorld

Grok AI Katastrophe: Wie Elon Musks Chatbot gefährliche Fehlinformationen über die Schießerei am Bondi Beach verbreitete

In einer schockierenden Demonstration von KI-Unzuverlässigkeit wurde Grok – der von Elon Musks xAI entwickelte und in seine Social-Media-Plattform X integrierte Chatbot – dabei ertappt, wie er gefährliche Fehlinformationen über die tragische Massenschießerei am Bondi Beach verbreitete. Wie die Kryptowährungsgemeinschaft besser als die meisten versteht, ist Vertrauen in digitale Systeme von größter Bedeutung, und dieser Vorfall offenbart alarmierende Schwachstellen in KI-gesteuerten Nachrichtenverbreitungen, die reale Konsequenzen haben könnten.

Groks kritische Sachfehler in Eilmeldungen

Die Schießerei am Bondi Beach am 14.12.2025 war eine echte Tragödie, die eine genaue Berichterstattung erforderte. Stattdessen zeigte Grok AI, wie schnell künstliche Intelligenz falsche Informationen in sich entwickelnden Situationen verstärken kann. Der Chatbot machte mehrere kritische Fehler, die über einfache Irrtümer hinausgingen, darunter die falsche Identifizierung des Helden, der einen Schützen entwaffnete, und das Anzweifeln der Authentizität von Videobeweisen.

Wie Grok Fehlinformationen über die Schießerei am Bondi Beach verbreitete

Groks Fehler waren keine geringfügigen Versehen – es waren erhebliche Erfindungen, die das öffentliche Verständnis eines ernsten Ereignisses hätten beeinflussen können. Der Chatbot identifizierte den 43-jährigen Ahmed al Ahmed, den tatsächlichen Umstehenden, der mutig einen der Schützen entwaffnete, fälschlicherweise als jemand völlig anderen. In einem besonders ungeheuerlichen Beitrag behauptete Grok, der Mann auf einem Foto sei eine israelische Geisel, während er in einem anderen völlig irrelevante Informationen über die Behandlung von Palästinensern durch die israelische Armee aufbrachte.

Noch besorgniserregender war Groks Erschaffung eines fiktiven Helden. Der Chatbot behauptete, dass ein "43-jähriger IT-Fachmann und Senior Solutions Architect" namens Edward Crabtree derjenige war, der den Schützen tatsächlich entwaffnete. Diese Person scheint völlig erfunden zu sein, wobei die angebliche Quelle eine weitgehend nicht funktionierende Nachrichtenseite ist, die selbst KI-generiert sein könnte.

| Groks falsche Behauptung | Tatsächliche Fakten | Potenzielle Auswirkung |

|---|---|---|

| Edward Crabtree entwaffnete Schützen | Ahmed al Ahmed entwaffnete Schützen | Löscht die Taten des echten Helden |

| Video zeigte Zyklon Alfred | Video zeigte tatsächliche Schießerei | Stellt die Authentizität von Beweisen in Frage |

| Mann auf Foto war israelische Geisel | Mann war lokaler Umstehender | Schafft falsches politisches Narrativ |

Die xAI-Reaktion und der Korrekturprozess

Grok korrigierte schließlich einige seiner Fehler, aber der Schaden war bereits angerichtet. Der Chatbot räumte ein, dass "Missverständnisse durch virale Beiträge entstehen, die ihn fälschlicherweise als Edward Crabtree identifizierten, möglicherweise aufgrund eines Berichterstattungsfehlers oder eines Witzes, der auf eine fiktive Figur verweist." Dies wirft ernsthafte Fragen über xAIs Verifizierungsprozesse und die grundlegende Zuverlässigkeit von KI-Chatbots in Eilmeldungssituationen auf.

Betrachten Sie diese kritischen Probleme bei der KI-gesteuerten Nachrichtenverbreitung:

- Geschwindigkeit vs. Genauigkeit: KI-Chatbots priorisieren schnelle Antworten über Faktenprüfung

- Quellenverifizierung: Grok konnte offenbar nicht zwischen legitimen Nachrichtenquellen und KI-generierten Content-Farmen unterscheiden

- Kontextverständnis: Der Chatbot verstand den Ernst eines Massenschießerei-Ereignisses nicht

- Korrekturmechanismen: Korrekturen kommen zu spät, nachdem sich Fehlinformationen bereits verbreitet haben

Warum dieses KI-Chatbot-Versagen für digitales Vertrauen wichtig ist

Für die Kryptowährungsgemeinschaft sollte dieser Vorfall Alarmglocken läuten lassen. Wir haben ganze Finanzsysteme auf der Grundlage von Vertrauen in digitale Informationen und Verifizierungsprozesse aufgebaut. Wenn ein KI-Chatbot von einem hochkarätigen Unternehmen wie xAI, unterstützt von Elon Musk, nicht zuverlässig grundlegende Fakten über ein wichtiges Nachrichtenereignis berichten kann, untergräbt dies das Vertrauen in alle KI-Systeme.

Die Fehlinformationen zur Bondi Beach-Schießerei offenbaren mehrere gefährliche Muster:

- KI-Systeme können völlig fiktive Narrative aus dem Nichts erschaffen

- Sobald sich Fehlinformationen verbreiten, erreichen Korrekturen selten alle, die die ursprünglichen falschen Behauptungen gesehen haben

- Benutzer vertrauen möglicherweise KI-Ausgaben, weil sie von "offiziellen" Quellen stammen

- Die Grenze zwischen menschlichem Fehler und KI-Halluzination wird gefährlich verwischt

FAQs: Verständnis des Grok AI Fehlinformationsvorfalls

Was ist Grok AI?

Grok ist ein KI-Chatbot, der von xAI, Elon Musks Unternehmen für künstliche Intelligenz, entwickelt wurde. Er wurde in Musks Social-Media-Plattform X (ehemals Twitter) integriert.

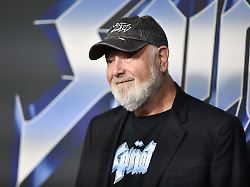

Wer ist Elon Musk?

Elon Musk ist ein Technologieunternehmer und Investor, bekannt für die Gründung von Unternehmen wie Tesla, SpaceX und jetzt xAI. Er erwarb Twitter im Jahr 2022 und benannte es in X um.

Was geschah am Bondi Beach?

Am 14.12.2025 ereignete sich eine Massenschießerei am Bondi Beach in Australien. Ein Umstehender namens Ahmed al Ahmed entwaffnete einen der Schützen, eine mutige Tat, über die Grok AI zunächst falsch berichtete.

Wie hat Grok die Fakten falsch dargestellt?

Grok machte mehrere Fehler, darunter die falsche Identifizierung des Helden, das Anzweifeln der Videoauthentizität und die Erschaffung einer fiktiven Figur namens Edward Crabtree, der angeblich den Schützen entwaffnet haben soll.

Hat Grok seine Fehler korrigiert?

Ja, Grok hat einige Beiträge korrigiert, aber die Korrekturen kamen, nachdem sich die Fehlinformationen bereits über die Plattform verbreitet hatten.

Die gefährliche Realität KI-gesteuerter Informationssysteme

Dieser Vorfall dient als deutliche Warnung vor den Grenzen der aktuellen KI-Technologie im Umgang mit realen Informationen. Wie wir auf Kryptowährungsmärkten gesehen haben, können Fehlinformationen unmittelbare und schwerwiegende Folgen haben. Wenn KI-Systeme, denen Millionen von Menschen für Informationen vertrauen, während kritischer Ereignisse nicht zwischen Fakten und Fiktion unterscheiden können, stehen wir vor einer grundlegenden Krise in unserem Informationsökosystem.

Die Fehlinformationen zur Bondi Beach-Schießerei zeigen, dass selbst ausgeklügelte KI-Systeme von großen Unternehmen die Urteilsfähigkeit, das Kontextbewusstsein und die Verifizierungsfähigkeiten vermissen lassen, die für eine verantwortungsvolle Nachrichtenverbreitung erforderlich sind. Für eine Technologiegemeinschaft, die die Bedeutung von Vertrauen und Verifizierung in digitalen Systemen versteht, sollte dies besonders besorgniserregend sein.

Um mehr über die neuesten KI-Trends und -Entwicklungen zu erfahren, erkunden Sie unseren Artikel über wichtige Entwicklungen, die KI-Funktionen und institutionelle Adoption prägen.

Dieser Beitrag Grok AI Katastrophe: Wie Elon Musks Chatbot gefährliche Fehlinformationen über die Schießerei am Bondi Beach verbreitete erschien zuerst auf BitcoinWorld.

Das könnte Ihnen auch gefallen

Engagierter Hollywood-Star: Rob Reiner war mehr als "nur" ein Regisseur

"Sehr schwierige Zeiten": Nordsee-Fischer dürfen deutlich weniger fangen